[s-market] 프로젝트 구조

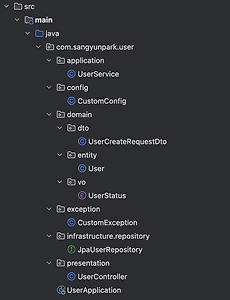

s-market 프로젝트 구조에 대해서 소개합니다. 전반적인 프로젝트 구조는 도메인 중심 설계(Domain Driven Design)와 레이어드 아키텍처를 기반으로 구성했습니다. 도메인 중심 설계를 선택한 이유는, 프로젝트 초기부터 비즈니스 중심의 코드 구조를 지향하고, 변화에 유연하게 대응할 수 있는 기반을 마련하기 위해서입니다.핵심 도메인 로직은 domain 계층에 집중시키고, DB 접근, 인증, 메시지 처리 등 기술적인 요소는 infrastructure로 분리하여 관심사의 분리와 계층 간 역할을 명확히 하고자 합니다.또한, 도메인 모델을 VO, Entity, DTO로 구분하고, 비즈니스 유스케이스는 application 계층에서만 다루도록 구성함으로써, 기술 구현과 도메인 로직이 서로 얽히지 않도..

2025. 3. 31.

[s-market] 프로젝트 구조

s-market 프로젝트 구조에 대해서 소개합니다. 전반적인 프로젝트 구조는 도메인 중심 설계(Domain Driven Design)와 레이어드 아키텍처를 기반으로 구성했습니다. 도메인 중심 설계를 선택한 이유는, 프로젝트 초기부터 비즈니스 중심의 코드 구조를 지향하고, 변화에 유연하게 대응할 수 있는 기반을 마련하기 위해서입니다.핵심 도메인 로직은 domain 계층에 집중시키고, DB 접근, 인증, 메시지 처리 등 기술적인 요소는 infrastructure로 분리하여 관심사의 분리와 계층 간 역할을 명확히 하고자 합니다.또한, 도메인 모델을 VO, Entity, DTO로 구분하고, 비즈니스 유스케이스는 application 계층에서만 다루도록 구성함으로써, 기술 구현과 도메인 로직이 서로 얽히지 않도..

2025. 3. 31.